کمیته رکن چهارم – بخش AWS آمازون تراشههایی برای آموزش هوش مصنوعی طراحی کرده و تلاش میکند با کمک آنها، با گوگل و مایکروسافت در حوزه AI رقابت کند.

در یک ساختمان اداری بینامونشان در آستین تگزاس، تعدادی از کارمندان آمازون درحال طراحی دو نوع ریزتراشه برای آموزش و شتابدادن به عملکرد هوش مصنوعی هستند. مشتریان سرویسهای وب آمازون (AWS) میتوانند این تراشههای سفارشیسازیشده با نامهای اینفرنشا (Inferentia) و ترینیوم (Trainium) را بهعنوان روشی جایگزین برای آموزش مدلهای زبانی بزرگ خود با پردازندههای گرافیکی انویدیا که درحال تبدیلشدن به فرایندی دشوار و پرهزینه است، استفاده کنند.

«آدام سلیپسکی»، مدیرعامل AWS، در مصاحبهای با رسانه CNBC در مورد این موضوع اینچنین گفته است: «متخصصان سراسر جهان علاقهمند به استفاده از تراشههای بیشتر برای هوش مصنوعی مولد هستند. به نظرم جایگاه ما برای تأمین ظرفیت موردنیاز مشتریانمان، نسبت به سایر شرکتها بهتر است.»

البته پس از شکوفایی شگفتانگیز AI، شرکتهای دیگر برای کسب درآمد در این حوزه، سریعتر عمل کرده و سرمایهگذاری بیشتری انجام دادهاند. زمانی که Open AI چتبات هوش مصنوعی ChatGPT را در نوامبر ۲۰۲۲ معرفی کرد، مایکروسافت با حمایت از این ابزار هوش مصنوعی پرطرفدار، توجه زیادی را به خود جلب کرد و براساس گزارشها، ۱۳ میلیارد دلار در Open AI سرمایهگذاری نمود (در برخی از منابع این رقم ۱۰ میلیارد دلار اعلام شده است). ردموندیها مدلهای هوش مصنوعی مولد را در محصولات خود ادغام و در ماه فوریه آنها را در موتور جستجوی خود، یعنی بینگ نیز ترکیب کردند.

در همان ماه، گوگل مدل زبانی بزرگ خود با نام بارد (Bard) را معرفی نمود و پس از آن ۳۰۰ میلیون دلار در آنتروپیک (Anthropic)، استارتاپ هوش مصنوعی رقیب Open AI، سرمایهگذاری کرد.

آمازون تازه در ماه آوریل خانواده مدلهای زبانی بزرگ خود با نام تیتان (Titan) را همراه با سرویسی تحت عنوان بدراک (Bedrock) جهت کمک به توسعهدهندگان بهمنظور تقویت عملکرد نرمافزاری با استفاده از AI مولد معرفی کرد. «چیراگ دیکات» (Chirag Dekate)، معاون تحلیلگر در شرکت تحلیلی گارتنر، در مورد ورود به حوزه هوش مصنوعی مولد اینچنین میگوید:

«آمازون به تعقیبکردن بازارها عادت ندارد و تنها به ایجاد آنها عادت دارد. این شرکت پس از مدتها، برای نخستینبار بهخاطر احساس تهدید، تدافعی عمل کرده و درحال تلاش برای رسیدن به رقبایش است.»

متا نیز اخیراً Llama 2، مدل زبانی بزرگ متنباز خود را که یکی دیگر از رقبای ChatGPT محسوب میشود، منتشر کرده که اکنون برای آزمایش در سرویس ابری عمومی مایکروسافت آژور در اختیار عموم کاربران قرار گرفته است.

استفاده از تراشههای AWS برای آموزش هوش مصنوعی

استفاده از تراشههای AWS برای انجام این کار واقعاً روش متمایزی است. دیکات در مورد این تراشهها اینچنین میگوید: «تراشههای سفارشی آمازون در بلندمدت میتوانند زمینه بهرهمندی از مزایای زیادی در حوزه هوش مصنوعی را فراهم کنند. به نظر من، آنچه استفاده از این تراشهها را از سایر روشها متمایز میکند، توانایی آنها برای امکانپذیر کردن بهرهمندی از قابلیتهای فنی است. به نظر شما دلیل این موضوع چیست؟ مایکروسافت تراشه اینفرنشا یا ترینیوم ندارد.»

AWS از سال ۲۰۱۳ تولید تراشه سفارشی را بیسروصدا با تکهای از سختافزاری خاص به نام نیترو (Nitro) آغاز کرد. این تراشه در میان تراشههای AWS، بالاترین حجم را دارد. آمازون اذعان کرده است در هر سرور AWS حداقل یک عدد از این تراشهها وجود دارد و درمجموع از ۲۰ میلیون تراشه سفارشی استفاده شده است.

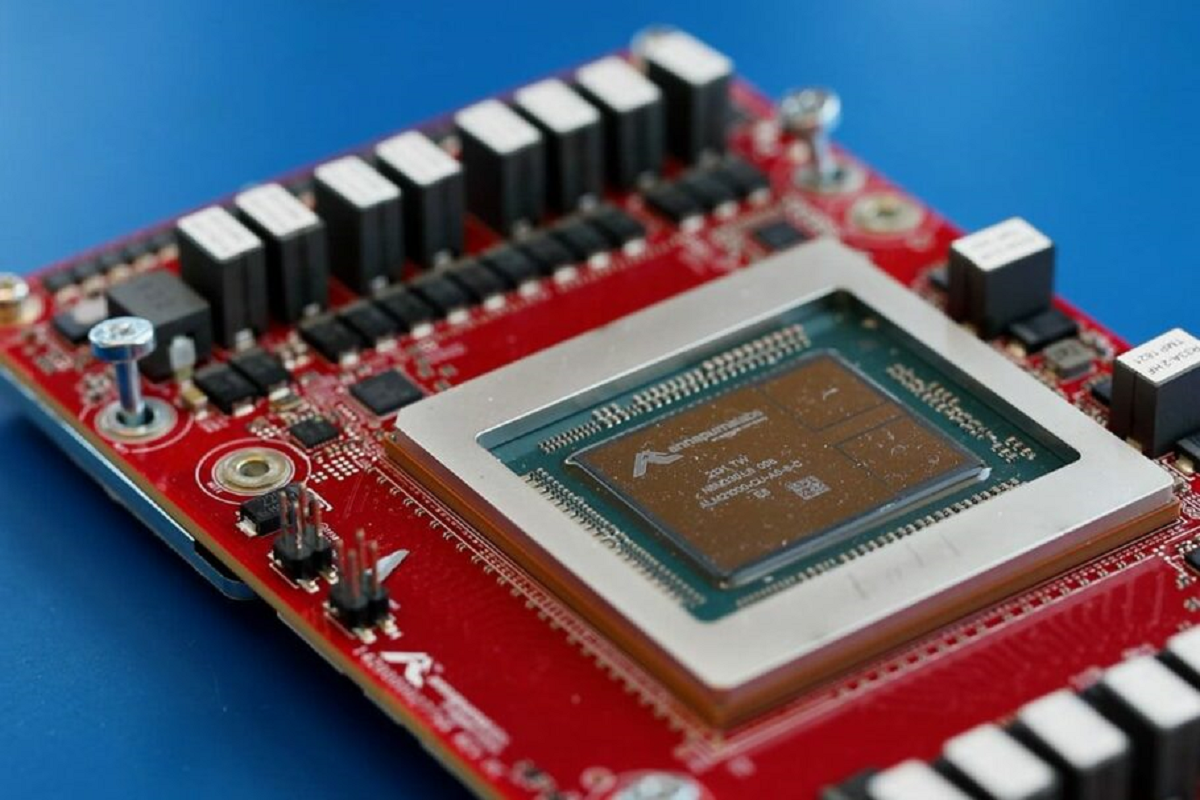

آمازون در سال ۲۰۱۵ استارتاپ تراشه آناپورا لبز (Annapurna Labs) را فروخت و سپس در سال ۲۰۱۸ تراشه سرور مبتنی بر معماری ARM خود به نام گراویتون (Graviton) را بهعنوان رقیبی برای تراشههای ۳۲ بیتی غولهای تراشهسازی مثل AMD و اینتل عرضه کرد. «استیسی راسگون» (Stacy Rasgon)، تحلیلگر ارشد شرکت تحلیلی برناستین ریسرچ (Bernstein Research)، در مورد این موضوع اینچنین میگوید: «احتمالاً تراشههای دارای معماری ARM درصد تکرقمی بالا یا حتی شاید ۱۰ درصد از کل فروش تراشههای سرور را به خود اختصاص دادهاند و بخش قابلتوجهی از این تراشهها را آمازون تولید کرده است. آمازون درزمینه تولید تراشههای ARM برای سیپییوها نیز عملکرد بسیار خوبی دارد.»

این غول فناوری آمریکایی در سال ۲۰۱۸ نخستین تراشههای متمرکز بر هوش مصنوعی خود را دو سال پس از معرفی واحد پردازشگر تنسور (Tensor Processor Unit یا TPU) توسط گوگل، عرضه کرد. طبق گزارشها، مایکروسافت نیز قصد دارد با مشارکت AMD، تراشه هوش مصنوعی خود با رمز آتنا (Athena) را که هنوز درحال کارکردن روی آن است، معرفی و عرضه کند.

«مت وود» (Matt Wood)، معاون بخش تولید تراشههای اینفرنشا و ترینیوم، میگوید: «فرایند یادگیری ماشینی به دو مرحله متفاوت تقسیم میشود. در اولین مرحله، مدلهای یادگیری ماشینی را آموزش میدهیم. در دومین مرحله، استنتاج را در برابر مدلهای آموزشدیده اجرا میکنیم. هزینه روش استفاده از ترینیوم برای آموزش مدلهای یادگیری ماشینی در AWS، بهاندازه ۵۰ درصد کمتر از سایر روشهای درحال استفاده برای انجام این کار است.»

ترینیوم در سال ۲۰۲۱، پس از عرضه اینفرنشا در سال ۲۰۱۹، برای نخستینبار به بازار عرضه شد و اکنون دومین نسل آن تولید شده است.

اینفرنشا به مشتریان اجازه میدهد استنتاجهای یادگیری ماشین را با هزینه فوقالعاده کم، توان عملیاتی بالا و تأخیر پایین اجرا کنند. استنتاجهای یادگیری ماشینی درحقیقت فرایندهای مرتبط با پیشبینیهای ورودیهای متنی تایپشده توسط کاربران در مدلهای هوش مصنوعی مولد و همچنین پردازش تمام دادهها برای پاسخ به کاربران هستند.

البته پردازندههای گرافیکی انویدیا هنوز هم سلطانهای بلامنازعی برای آموزش مدلهای AI محسوب میشوند. AWS در ماه جولای سختافزار شتابدهنده هوش مصنوعی جدید خود را که از پردازندههای گرافیکی H100 انویدیا استفاده میکند، معرفی کرد.

راسگون در مورد این موضوع اینچنین میگوید: «تراشههای انویدیا اکوسیستم نرمافزاری گستردهای دارند و در ۱۵ سال اخیر این اکوسیستم طوری پیرامون تراشهها ایجاد شده که هیچ شرکتی موفق به انجام این کار نشده است. درحالحاضر انویدیا برنده بزرگی در حوزه هوش مصنوعی محسوب میشود.»

تسلط AWS در حوزه رایانش ابری، برگ برنده آمازون است

دیکات در مورد این موضوع اینچنین میگوید: «آمازون نیازی ندارد که سرخط خبرها را از آن خود کند. این شرکت قبلاً موفق به ایجاد تأسیسات ابری قدرتمندی شده است. این شرکت تنها نیاز دارد ببیند که چگونه میتواند مشتریان موجود را بیشتر درگیر ارزشآفرینی با استفاده از هوش مصنوعی مولد کند.»

وقتی که برای استفاده از AI مولد باید از بین آمازون، گوگل و مایکروسافت دست به انتخاب زد، ممکن است میلیونها مشتری AWS بهسمت آمازون کشیده شوند؛ زیرا قبلاً با آن آشنا شدهاند، اپلیکیشنهای خود را روی AWS اجرا و دادههای خود را در پلتفرم ابری آمازون ذخیره کردهاند.

«می-لان تامسن بوکوک» (Mai-Lan Tomsen Bukovec)، معاون بخش فناوری AWS، در مورد این موضوع اینچنین میگوید: «مسئله سرعت است. میزان سرعت شرکتهای مذکور درزمینه حرکت بهسمت توسعه کاربردهای هوش مصنوعی مولد، ابتدا با شروع استفاده از دادههای موجود در AWS و استفاده از ابزارهای محاسباتی و یادگیری ماشینی ارائهشده توسط ما، مشخص میشود.»

شرکت فعال در حوزه پژوهش صنعت فناوری، AWS بزرگترین تأمینکننده سرویس رایانش ابری در جهان محسوب میشود و در سال ۲۰۲۲، ۴۰ درصد از سهم این بازار را از آن خود کرده است. اگرچه یک ردیف درآمد عملیاتی AI در سه فصل، در مقایسه با سال گذشته کاهش یافته، اما هنوز ۷۰ درصد از سود عملیاتی کلی ۷.۷ میلیارد دلاری آمازون در فصل دوم، به این بخش از شرکت مربوط است.

حاشیه سود عملیاتی AWS از گذشته تاکنون همیشه به میزان زیادی بیشتر از این بخش از درآمد پلتفرم ابری گوگل کلود بوده است. AWS پرتفولیوی درحالرشد از ابزارهای تهیهشده برای توسعهدهندگان، با تمرکز بر هوش مصنوعی مولد نیز دارد.

«سوامی سیواسوبرامانیان» (Swami Sivasubramanian)، معاون بخش پایگاه داده، تحلیلها و یادگیری ماشینی، در مورد این موضوع اینچنین میگوید: «اجازه دهید زمان را به قبل و حتی قبل از انتشار ChatGPT بازگردانیم. اتفاقات آن زمان مانند اتفاقات پس از انتشار این چتبات نبود. پس از انتشار ChatGPT ناگهان عجله کردیم و کار خود را با یک برنامه آغاز نمودیم؛ زیرا مهندسیکردن یک تراشه در مدتزمان کوتاه امکانپذیر نبود و ایجاد یک سرویس بدراک در طول ۲ یا ۳ ماه اصلاً نشدنی بود.»

سرویس بدراک دسترسی مشتریان به مدلهای زبانی بزرگ تهیهشده توسط آنتروپیک، استیبیلیتی اِی.آی (Stability AI)، ای.آی ۲۱ لبز (AI21 Labs) و تیتان (Titan) را که به خود آمازون تعلق دارد، فراهم کرده است.

سیواسوبرامانیان در مورد این موضوع اینچنین میگوید: «ما اصلاً قبول نداریم که در آینده یک مدل در تمام دنیا حکمرانی خواهد کرد. ما میخواهیم مشتریانمان به جدیدترین مدلهای مختلف از چند ارائهدهنده دسترسی داشته باشند؛ زیرا آنها میخواهند ابزار مناسب را برای کار خود انتخاب کنند.»

یکی از جدیدترین سرویسهای پیشنهادی آمازون در حوزه هوش مصنوعی، هلث اسکرایب (AWS HealthScribe) است. این سرویس که در ماه جولای رونمایی شد، به پزشکان کمک میکند پس از ویزیت بیمار، با استفاده از AI مولد، پیشنویسی از خلاصه اطلاعات مهم تهیه کنند. آمازون یک سرویس یادگیری ماشینی به نام سیج میکر (SageMaker) نیز ایجاد کرده که برای ارائه الگوریتمها، مدلها و سایر موارد تهیه شده است.

یکی دیگر از ابزارهای بزرگ AI آمازون ابزاری برای کمک به کدنویسی تحت عنوان کد ویسپر (CodeWhisperer) است که این شرکت میگوید توسعهدهندگان با استفاده از آن میتوانند برنامهنویسی را به میزان ۵۷ درصد زودتر از زمان متوسط به پایان برسانند. مایکروسافت نیز سال گذشته اعلام کرد ابزار کدنویسی هوش مصنوعی این شرکت، یعنی گیتهاب کوپایلت (GitHub Copilot) باعث بهبود عملکرد برنامهنویسی شده است.

AWS در ماه ژوئن خبر سرمایهگذاری ۱۰۰ میلیون دلاری برای ایجاد یک مرکز مبتکرانه هوش مصنوعی مولد را اعلام کرد.

سلیپسکی، مدیرعامل آمازون، در مورد تمایل عموم مردم برای بهرهمندی از تواناییهای AI مولد اینچنین میگوید: «ما مشتریان زیادی داریم که میگویند میخواهیم از هوش مصنوعی مولد استفاده کنیم؛ اما آنها لزوماً نمیدانند معنا و مفهوم استفاده از این فناوری در کسبوکارشان چیست. ما قصد داریم تعدادی از معماران نرمافزار، استراتژیستها و دانشمندان داده را استخدام و با تکتک آنها کار کنیم.»

اگرچه AWS تاکنون بهجای تمرکز برای ساخت رقیبی برای ChatGPT، بیشتر روی ساخت ابزارها متمرکز شده، اما اخیراً ایمیلی از داخل این شرکت افشا شده است که نشان میدهد اندی جسی، مدیرعامل آمازون نیز مستقیماً درحال نظارت روی روند ایجاد یک تیم مرکزی جدید برای ایجاد مدلهای زبانی بزرگ پرهزینه است.

اندی جسی در گزارش مالی فصل دوم اذعان کرده که درحالحاضر بخش بسیار قابلتوجهی از کسبوکار AWS توسط هوش مصنوعی و بیش از ۲۰ سرویس یادگیری ماشینی درحال ارائه توسط این بخش، هدایت میشود. تعدادی از مشتریان شاخص AWS شرکتهای فیلیپس، ۳M، اولد میچوال (Old Mutual) و HSBC هستند.

رشد انفجاری فناوری AI موجی از نگرانیهای امنیتی را بهوجود آورده است؛ این نگرانیهای امنیتی از سوی شرکتهایی مطرح شده که کارمندان آنها اطلاعات خصوصی شرکت را در میان دادههای آموزشی درحال استفاده توسط مدلهای زبانی بزرگ عمومی قرار دادهاند و این موضوع آنها را نگران کرده است.

سلیپسکی در مورد این موضوع اینچنین میگوید: «تعداد شرکتهای فورچون ۵۰۰ که در هنگام صحبت با آنها متوجه شدهام استفاده از ChatGPT را ممنوع کردهاند، از دستم در رفته است؛ بنابراین براساس رویکرد ما نسبت به هوش مصنوعی مولد و سرویس بدراک، هر کاری که انجام میدهید و هر مدلی که در بدراک استفاده میکنید، به محیط ابری شخصی مجازی ایزوله شما تبدیل میشود. مدل موردنظر رمزگشایی خواهد شد و تمام مدلها دسترسی کنترلکننده یکسانی به AWS خواهند داشت.»

درحالحاضر آمازون تنها درحال تسریع پیشرفت خود در حوزه هوش مصنوعی مولد بوده و به CNBC گفته است که درحالحاضر بیش از ۱۰۰ هزار مشتری از طریق AWS درحال استفاده از فناوری یادگیری ماشینی هستند.

البته براساس تحلیلها، ممکن است درصد کمی از مشتریان AWS پلتفرم دیگری را برای این کار انتخاب کنند.

دیکات در مورد این موضوع اینچنین میگوید: «آنچه ما نمیبینیم، گفتههای سازمانهاست. مایکروسافت درزمینه هوش مصنوعی مولد بسیار پیشتاز است. اجازه دهید استراتژیهای زیرساختی خود را تغییر دهیم و همهچیز را به مایکروسافت منتقل کنیم. اگر مشتری آمازون هستید، احتمالاً در آینده با اکوسیستم بسیار گستردهای برای آمازون مواجه خواهید شد.»

منبع : دیجیاتو