کمیته رکن چهارم – سازمان دارپا در حال تحقیق روی نظریه هایی است که به کمک آن بتواند حجم داده های مورد نیاز برای آموزش هوش مصنوعی را کاهش دهد.

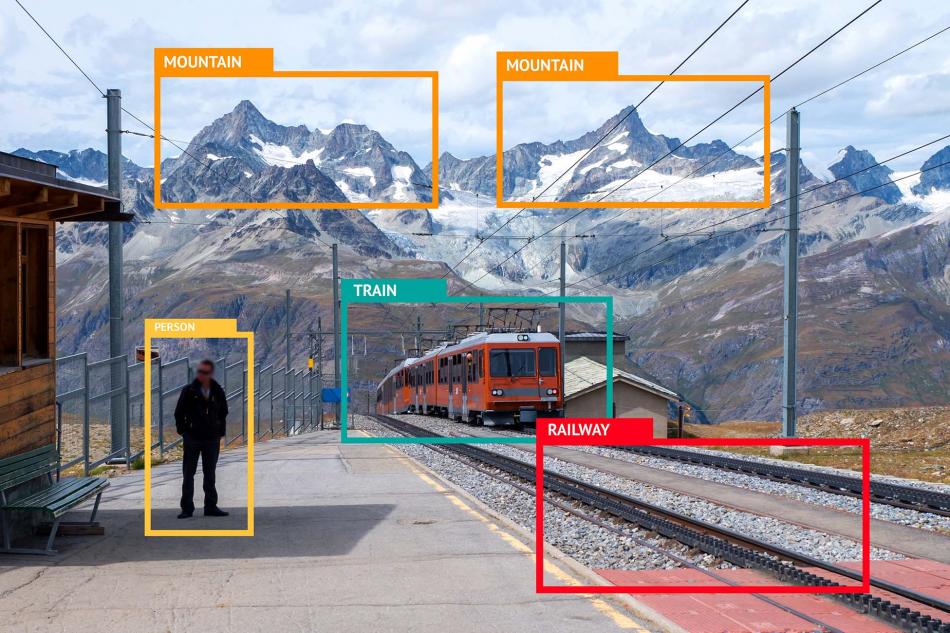

سامانه های یادگیری ماشینی امروزی، به منظور تولید خروجی با استفاده از حجم عظیمی از داده ها که توسط تحلیلگران انسانی ایجاد و برچسب گذاری می شوند، آموزش می بینند. به مرور زمان و با پیشرفت این فناوری شبکه عصبی عمیق (DNN) به وجود آمد که وظایفی مانند ترجمه ماشینی، تشخیص گفتار یا شناسایی اشیا را با دقتی بسیار بالا انجام می دهد.

فناوری یادگیری عمیق برای آموزش به تعداد بسیار بالایی داده ی علامت گذاری شده (〖۱۰〗^۹ یا〖۱۰〗^۱۰ نمونه) نیاز دارد؛ اما آماده سازی این داده ها زمان و هزینه ی بسیاری را به خود اختصاص می دهد. از طرفی بسیاری از الگوریتم های یادگیری ماشینی با ایجاد کوچک ترین تغییری در محیط عملیاتی با شکست مواجه می شوند. برای نمونه اگر تغییر یاد شده در یک اتاق عایق صوت یا حسگر میکروفن رخ دهد، یک سامانه ی تشخیص گفتار به حجم عظیمی از داده های جدید احتیاج پیدا می کنند. اصلاح الگوریتم به کار گرفته شده برای شرایط تازه تقریباً به همان اندازه ی زمان ایجاد آن انرژی و وقت نیاز دارد.

سازمان دارپا به منظور کاهش زمان و هزینه ی مورد نیاز برای آموزش و تطبیق یادگیری ماشینی، برنامه ای به نام «یادگیری با برچسب های کمتر» (LwLL1) را راه اندازی کرد. در این طرح روی الگوریتم های یادگیری جدیدی تحقیق می شود که تا حد زیادی وابستگی به داده ها را برای آموزش و بروزرسانی کاهش می دهند.

وید شن (Wade Shen)، مدیر برنامه ی دفتر نوآوری اطلاعات و رهبر پروژه ی مذکور گفت:

ما در طرح یادگیری با برچسب های کمتر، نیازمند کاهش اطلاعات مورد نیاز برای ساخت مدل ها هستیم تا از میلیون ها داده ها به صدها نمونه کاهش پیدا کنند. به این معنی که الگوریتمی که امروزه برای آموزش به یک میلیون تصویر نیاز دارد، در آینده تنها با یک عکس آموزش می بیند. یا تنها با حدود یک صد نمونه ی نشانه گذاری شده خود را تطبیق می دهد.

محققان به منظور دستیابی به هدف بالا روی دو زمینه ی فنی مختلف تحقیق می کنند. حوزه ی اول روی ایجاد الگوریتم های یادگیری تمرکز دارد که به شکلی مؤثر یادگرفته، سازگار می گردند. پژوهشگران فعال در این زمینه الگوهایی را توسعه می دهند که بدون به خطر انداختن عملکرد سامانه، قابلیت کاهش داده های مورد نیاز را دارد.

شن ادامه داد:

ما پژوهشگران را تشویق کردیم به منظور رفع چالش های یاد شده روی ایجاد مدل های جدید در Meta-learning، Active Learning، K-shot Learning، یادگیری با نظارت و بدون نظارت تحقیق کنند.

در حوزه دوم کارشناسان در زمینه ی مشخص کردن مسائل یادگیری الگوریتم ها به چالش کشیده می شوند. هدف تعیین پیچیدگی های تصمیم گیری و نوع داده های واقعی مورد استفاده است.

وی افزود:

امروزه درک این مسئله که یک الگوریتم مؤثر چگونه ساخته می شود و محدودیت های ایجاد یک سامانه با سطح دقتی مشخص بسیار مشکل است. ما امیدواریم در قالب پروژه ی مذکور بتوانیم محدودیت های نظری این حوزه را شناسایی کنیم و آنها را به منظور توسعه سیستم و توانایی های آن به کار ببریم.

منبع : سایبربان