کمیته رکن چهارم – لابراتور تحقیقاتی OpenAI با وجود هشدارهایی مبنیبر خطرناکبودن GPT-2، نسخهی کامل سیستم هوش مصنوعی تولیدکنندهی متن خود را منتشر کرد.

لابراتور تحقیقاتی OpenAI نسخهی کامل سیستم هوش مصنوعی تولیدکنندهی متن بهنام GPT-2 را منتشر کرده است. این موفقیت در حالی حاصل شده است که کارشناسان هشدار دادند این سیستم هوش مصنوعی میتواند برای اهداف مخرب استفاده شود. GPT-2 مخفف واژههای Generative Pretrained Transformer است. حرف G مخفف واژهی Generative بهمعنای «تولیدکننده یا زایا» و حرف P مخفف واژهی Pretrained بهمعنای «پیشآموزش دادهشده» و حرف T مخفف واژهی Transformer بهمعنای «مبدل یا ترنسفورمر» است.

در فوریهی سال جاری، مؤسسهی تحقیقاتی OpenAI فناوری خارقالعادهی GPT-2 را رونمایی کرد که میتوانست با کمترین دخالت انسانی، متونی منسجم شامل چندین پاراگراف را از خود بنویسد. حتی در توضیحات گاردین اینگونه آمده بود که این سیستم هوش مصنوعی متون چندکلمهای تا یکصفحهای را بهعنوان ورودی دریافت میکند و میتواند چندین جمله را باتوجهبه پیشبینیهای خود درادامهی آن بنویسد.

بااینهمه، OpenAI بهدلیل نگرانیهای ناشی از سوءاستفادههای احتمالی ازقبیل انتشار اخبار جعلی و هرزنامهها و اطلاعات نادرست، نسخهی کامل این فناوری را منتشر نکرد. از آن زمان نسخههای کوچکتر و کمتری از GPT-2 منتشر شده است و پذیرش آنها مطالعه شده است. برخی دیگر نیز GPT-2 را نیز بارها آزمایش کردهاند. درنهایت، لابراتور تحقیقاتی OpenAI این هفته در پستی در وبلاگ خود نوشت:

هیچ مدرک محکمی دربارهی سوءاستفاده و مخرببودن GPT-2 وجود ندارد؛ ازاینرو، نسخهی کامل این فناوری منتشر شده است.

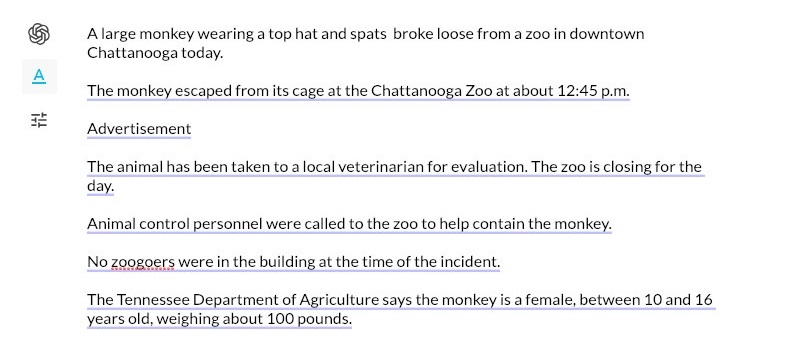

نمونهی تولید متنی از الگوریتم مدلسازی زبان OpenAI GPT-2

هوش مصنوعی زبانی GPT-2 بخشی از نسل جدیدی از سیستمهای تولید متن است که متخصصان را تحتتأثیر توانایی خود برای تولید متن منسجم با دراختیارداشتن حداقل دادهها قرار داده است. بهطور خاص، OpenAI هوش مصنوعی GPT-2 را برپایهی دادههای متنی دریافتشده آموزش داده است که کاربران و نویسندگان ارسال کردهاند. تمام دادههای گرفتهشده از لینکهای وب و متن بودند؛ بههمیندلیل، به دیتاست بهدستآمده WebText گفته شد. بیش از ۴۰ گیگابایت دادهی اینترنتی بههمراه تقریبا ۱/۵ میلیارد پارامتر از ساختارهای متنی برای آموزش GPT-2 بهکار گرفته شده است. بهعنوان مثال، میتوانید تنها با دادن عنوانی جعلی، از GPT-2 بخواهید مطلبی دربارهی آن بنویسد یا فقط با ارائهی مصرعی از یک شعر، کل شعر را از GPT-2 تحویل بگیرید.

پیبردن به عملکرد هوش مصنوعی زبانی GPT-2 از روی خروجی دادههای آن بسیار دشوار است؛ اما این مدل زبانی اغلب نوشتههای پررمزورازی تولید میکند که حتی میتوان نشانههایی از شعور یا هوش را در آن ردیابی کرد. این بدان معنا نیست که GPT-2 نیز مجهز به همان قدرت و ویژگی است که ما آن را بهعنوان شناخت میشناسیم. اگر با این سیستم به اندازهی کافی کار کنید، محدودیتهای آن نیز برایتان بهخوبی مشخص خواهد شد. یکی از ضعفهای آن در حفظ انسجام متون بلند است. برای نمونه، استفاده از نامها و صفتهای شخصیتها بهطور مداوم در داستان یا اصرار بر نوشتن دربارهی موضوع واحد در مقالهای خبری.

بهترین روش برای تخمین قابلیتهای GPT-2 این است که خودتان آن را امتحان کنید. برای دسترسی به این سیستم، میتوانید به نسخهی وب در TalkToTransformer.com مراجعه کنید و پیام و سوال خودتان را مطرح کنید. واژهی «ترنسفورمر» مؤلفهای از معماری یادگیری ماشین است که برای ایجاد GPT-2 و دیگر بخشهای آن استفاده میشود. گفتنی است ترنسفورمرها معماری بینظیری از شبکههای عصبی هستند.

جدا از قابلیتهای خام GPT-2، انتشار این مدل بهعنوان بخشی از بحث دربارهی مسئولیتپذیری پژوهشگران هوش مصنوعی برای کاهش آسیبهای ناشی از کار درخورتوجه است. کارشناسان پیشتر نیز خاطرنشان کرده بودند دسترسی آسان به تمام ابزارهای این هوش مصنوعی میتواند به فعال کردن بخشهای مخربی منجر شود. برای نمونه، پویاییای که در این فناوری وجود دارد، میتواند با مونتاژ تصویر چهرهی فردی روی چهرهی فردی دیگر، به تولید ویدئوهای جعلی یا دیپفیک (Deepfake) منجر شود. بنابراین، بهدلیل وجود چنین نگرانیهایی، OpenAI انتشار مدل خود را محدود کرده است.

شایان ذکر است همه از این رویکرد لابراتوار OpenAI استقبال نکردهاند و بسیاری از کارشناسان با انتقاد از چنین تصمیمی، بیان کردند با انجام این کار دامنهی تحقیقاتی کسانی محدود میشود که این مدل را کاهش میدهند و توقعهای غیرضروری دربارهی خطرهای هوش مصنوعی ایجاد خواهد کرد. دلیپ رائو، پژوهشگر این پروژه به خبرگزاری The Verge گفت:

کلمات بسیار خطرناک هستند؛ بهخصوص زمانیکه بدون هیچ تفکری و تنها با آزمایش تولید خواهند شد. فکر نمیکنم [OpenAI] وقت کافی را برای اثبات خطرناک بودن این سیستم صرف کند.

OpenAI در بیانیهای که این هفته دربارهی مدل کامل GPT-2 منتشر کرده بود، خاطرنشان کرد GPT-2 این سیستم میتواند به تولید «تبلیغات مصنوعی» برای موقعیتهای ایدئولوژیک افراطی کمک کند؛ ازاینرو، ممکن است با استناد به تحقیقات شخص ثالث از آن سوءاستفاده شود. اگرچه OpenAI بر ترس و نگرانی خود اعتراف کرد و گفت ممکن است از این سیستم برای بیرونکشیدن حجم زیاد اسپم منسجم یا بسیاری از سیستمهای اطلاعاتی آنلاین عملینشده مانند رسانههای اجتماعی استفاده شود.

همچنین، این لابراتوار خاطرنشان کرد پژوهشگران خود OpenAI سیستمهای خودکاری ایجاد کردند که میتواند خروجی GPT-2 را با دقت ۹۵ درصدی تشخیص دهند؛ اما این رقم برای «تشخیص سیستم خودکفا» کافی نیست؛ یعنی هر سیستمی که برای شناسایی خودکار متن جعلی موردنیاز باشد، بهتنهایی کافی نیست و درنهایت، برای تشخیص نهایی به داوری انسانی نیازمند است. گرچه انجام چنین کارهایی اغلب عجیب نیست که متکی به تشخیص و شناسایی نهایی انسان در این سیستم باشد؛ بهویژه برای تشخیص جعلی بودن یا نبودن تصاویر و ویدئوها.

OpenAI قصد دارد فعلا نظارهگر نحوهی استفادهی جامعه و عموم مردم از GPT-2 باشد تا در آینده، بهتر بتواند سیاستهای خود را دربارهی انتشار مسئولبودن تحقیقات هوش مصنوعی تدوین کند.

منبع : زومیت